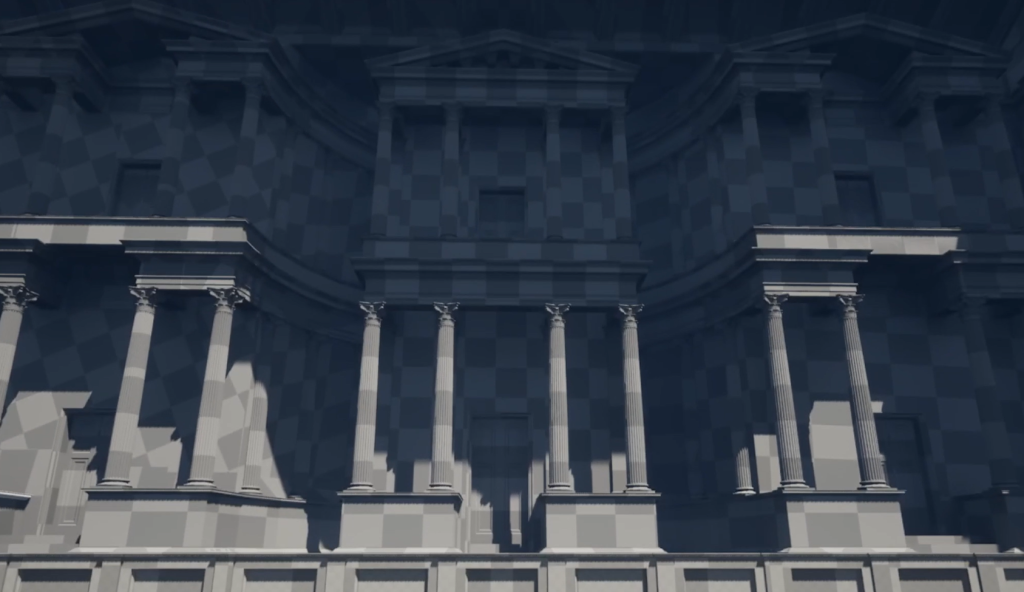

Przykład procesu tworzenia rekonstrukcji cyfrowej teatru antycznego w Volterze na podstawie danych architektonicznych z systemów BIM

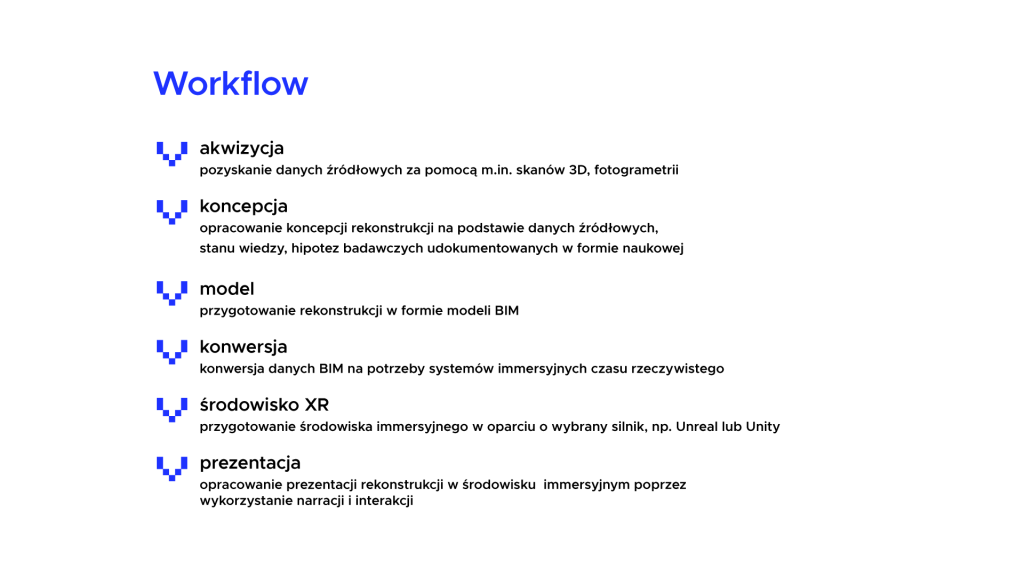

Praktyczny przykład wykorzystania frameworka (use case) wypracowanego w ramach przedsięwzięcia stanowi wirtualne środowisko immersyjne przedstawiające propozycję rekonstrukcji teatru rzymskiego w miejscowości Volterra w Toskanii. Zostało ono opracowane w oparciu o materiały i ustalenia wypracowane w poszczególnych krokach workflow.

Opracowany use case Volterra VR stanowi nie tylko praktyczne zastosowanie frameworka, ale również możliwość przybliżenia zarówno możliwości, jak i wyzwań związanych z przygotowaniem środowiska immersyjnego oraz związanych z tym rekomendacji. Realizacja use case’u pozwoliła na weryfikację wyzwań technicznych i organizacyjnych dotyczących kroków bezpośrednio związanych z konwersją elementów wirtualnego świata (krok 4) i tworzeniem spójnego środowiska immersyjnego czasu rzeczywistego (krok 5), jako podstawy do stworzenia struktury narracyjnej (krok 6) docelowego systemu prezentującego określoną spójną wizję rekonstrukcji obiektu dziedzictwa kulturowego. Warto w tym miejscu zauważyć, iż samo przygotowanie środowiska wirtualnego (VR) wysokiej jakości (High Fidelity), niezależnie od złożoności wspomnianego kontekstu workflow (kroki 1-3) jest stosunkowo dużym wyzwaniem technicznym, które wymaga od pracujących nad nim zespołów połączenia różnych umiejętności i kompetencji z zakresu wykorzystania silników czasu rzeczywistego, w tym w zakresie software i content developmentu.

W ramach realizacji use case Volterra przygotowaliśmy propozycję zastosowania kompleksowego podejścia z użyciem postulatów, kontekstów i wytycznych zawartych we frameworku Archiverse, w rezultacie uzyskując przykładowe środowiska immersyjne dostosowane do możliwości zarówno stacjonarnych, jak i mobilnych zestawów do rzeczywistości wirtualnej. Zgodnie z przyjętym procesem tworzenia rekonstrukcji (workflow), w ramach studium przypadku (use case) teatru rzymskiego w Volterze wykorzystaliśmy kluczowe elementy workflow, wsparte na doświadczeniu naszego zespołu z projektów wykorzystujących immersyjne środowiska wirtualne, poszerzone o transdyscyplinarny kontekst międzydziedzinowy, uzyskany we współpracy z Volterra-Detorit Foundation.

W szczególności dzięki uczestnictwu w latach 2022-2024 w cyklu warsztatów Digital Preservation Workshop organizowanych przez Volterra-Detroit Foundation uzyskaliśmy możliwość dostępu zarówno do danych zgromadzonych w ramach poprzednich warsztatów, w tym danych źródłowych na różnym stopniu przetworzenia (skany, chmury punktów) oraz modeli stworzonych przez prof. Fuchsa, jak również mieliśmy okazję wziąć aktywny udział we wszystkich krokach poprzedzających wykonanie samego środowiska, co pozwoliło zarówno na opracowanie i weryfikację kroków workflow, jak i praktyczną realizację w oparciu o use case teatru Volterra.

Przygotowane wizualizacje w ramach use case, w postaci środowiska immersyjnego VR, zostały oparte o modele przygotowane przez prof. Fuchsa. Modele wykorzystują możliwości zaawansowanych systemów BIM (krok 3), w szczególności oddają precyzyjnie aspekty architektoniczno-przestrzenne wirtualnej rekonstrukcji, na podstawie skanów cyfrowych i fotogrametrii (krok 1). Dzięki wcześniejszemu uczestnictwu w warsztatach i wizytach studyjnych w Volterze, nasz zespół pogłębił również wiedzę i doświadczenie, poprzez bezpośredni kontakt z badaczami i specjalistami z wielu dziedzin, od architektury, poprzez pomiary terenowe po archeologię. Bazując na efektach wcześniejszej pracy prof. Fuchsa oraz uczestników warsztatów Voltera-Detroit Foundation przeprowadzono również dalsze badania kontekstowe z udziałem szerokiego grona specjalistów, które pozwoliły pogłębić i poszerzyć kontekst rekonstrukcyjny (punkt 2 workflow), udowadniając jednocześnie, zasadność tego kroku i jego miejsce w procesie.

Mając na uwadze konieczność utrzymania w toku całego procesu (kolejnych kroków workflow) dbałości o niezbędny kontekst międzydziedzinowy, w tym architektoniczny, archeologiczny, historyczny, kulturowy i społeczny, należy raz jeszcze podkreślić wyraźnie, iż same aspekty techniczne związane z przygotowaniem dowolnego immersyjnego środowiska wirtualnego wysokiej wierności (High Fidelity VR) stanowią zazwyczaj ogromne wyzwanie, związane z wykorzystaniem narzędzi, w tym silników grafiki czasu rzeczywistego stosowanych w zaawansowanych produkcjach w branży gier komputerowych, a nawet produkcji filmowej. W ramach przedsięwzięcia bazowaliśmy na wieloletnim doświadczeniu naszego zespołu w zakresie tworzenia zaawansowanych immersyjnych środowisk wirtualnych czasu rzeczywistego z wykorzystaniem rozwiązań Mixed Reality Continuum (MR), obejmujących rzeczywistość wirtualną (VR – Virtual Reality), rozszerzoną (AR – Augmented Reality) i poszerzoną (XR – eXtended Reality).

Prace nad use case, w ramach kroków 4-5 workflow, prowadzono wieloaspektowo i wielotorowo, mając na uwadze przede wszystkim uniwersalność procesu z uwzględnieniem docelowej platformy (stacjonarna i mobilna) oraz możliwości i ograniczeń silników czasu rzeczywistego, w tym dwóch głównych używanych na potrzeby immersyjnych środowisk wirtualnych, czyli Unreal Engine (UE) i Unity, w kontekście automatyzacji procesu oraz różnorodnych wyzwań związanych z procesem kreacji środowiska immersyjnego.

W szczególności w toku przygotowania use case zweryfikowano możliwości zautomatyzowanej konwersji, w oparciu o systemy BIM firmy Autodesk, używane przez zespół Volterra-Detroit Foundation. Pomimo zaawansowanej współpracy pomiędzy firmą Autodesk, producenta zaawansowanych systemów BIM z firmą Epic Games, producentem zaawansowanego oprogramowania do generowania interaktywnych immersyjnych środowisk w czasie rzeczywistym Unreal Engine (UE) w toku prac nad use-case okazało się, iż aktualny poziom integracji rozwiązań obu producentów pozwala co prawda na zautomatyzowaną konwersję pomiędzy systemami BIM a silnikiem renderującym Unreal, m.in. w oparciu o moduł TwinMotion, niemniej rezultaty zautomatyzowanej konwersji pozwalają raczej na przygotowanie wizualizacji w postaci prerenderowanej sceny. W szczególności warto podkreślić, iż uzyskane rezultaty zautomatyzowanej konwersji zachowują co prawda układ architektoniczny oraz ułożenie elementów sceny zgodny z oryginałem przygotowanym w BIM, niemniej uzyskana automatyczna scena w Unreal Engine jest zbyt złożona w stosunku do możliwości bezpośredniego wykorzystania na potrzeby interaktywnej wizualizacji VR w czasie rzeczywistym.

Warto w tym miejscu zauważyć, iż mając na uwadze postęp w zakresie metod i technik automatyzacji, w tym sztucznej inteligencji i uczenia maszynowego oraz wspomnianą współpracę podmiotów odpowiedzialnych za kluczowe elementy i narzędzia procesu zautomatyzowanej konwersji należy zakładać, iż prawdopodobnie stopień automatyzacji na potrzeby środowisk czasu rzeczywistego ulegnie w przyszłości zmianie. Niemniej na chwilę obecną proces ten jest dość złożony i wymaga wysokich kompetencji, tym bardziej zatem w mocy pozostaje postulat kontekstowy workflow dotyczący traktowania systemów VR jako jedynie sposobu wizualizacji w postaci immersyjnego środowiska z użyciem aktualnie dostępnych rozwiązań, na podstawie danych źródłowych w postaci repozytoriów danych surowych (skany, chmury) oraz modeli (BIM), również z uwagi na postępujący rozwój technologiczny i potencjalne przyszłe możliwości zautomatyzowanej wizualizacji.

Mając na uwadze powyższe uwarunkowania w ramach opracowywania use case zdecydowano na wykorzystanie procesów częściowo zautomatyzowanych, m.i.n. z wykorzystaniem modułu konwersji DataSmith, pozwalającego na podstawie modeli BIM uzyskać niezbędne elementy interaktywnej sceny VR (modele, tekstury itp.), wymagające jednakże ponownego ułożenia w UE, na podstawie modeli referencyjnych BIM, a następnie zastosowania zaawansowanych możliwości UE (Nanite, Lumen). Podobny schemat zastosowano w przypadku Unity, gdzie proces automatyzacji był nieco niższy, z uwagi na brak gotowych modułów konwertujących. Zastosowano zatem tradycyjne podejście z wykorzystaniem retopologii oraz dopasowania elementów sceny do modeli referencyjnych (BIM). W odróżnieniu do Unreal Engine Unity upraszcza w pewnym stopniu produkcję środowisk na potrzeby VR, poprzez dostęp do odpowiedniego procesu przetwarzania danych na potrzeby renderingu w czasie rzeczywistym, w oparciu o dedykowany rendering pipeline. Unity w aktualnej wersji 6 posiada trzy rendering pipeline: standardowy (wbudowany) oraz dwa dodatkowe w pełni modyfikowalne (skryptowe) – URP (Uniwersal Rendering Pipeline) oraz HDRP (High Definition Rendering Pipeline). Zgodnie z zaleceniami producenta, URP jest rekomendowany do tworzenia rozwiązań VR na platformy mobilne (takie jak Oculus Quest), zaś HDRP na platformy stacjonarne, wyposażone w wysokowydajne podsystemy graficzne z modułem sprzętowego ray tracingu (np. Nvidia RTX), pozwalając uzyskać rezultaty porównywalne z generowanymi przy użyciu silnika Unreal Engine.

Warto również zauważyć, iż zaawansowane narzędzia, metody i techniki, które wprowadzono wraz z nową wersją UE, w tym zautomatyzowane zarządzanie geometrią obiektów (Nanite) oraz dynamicznym oświetleniem (Lumen) mimo wszystko mogą zostać wykorzystane jedynie w przypadku zaawansowanych stacjonarnych zestawów VR, wykorzystujących najnowsze karty graficzne wyposażone w sprzętową akcelerację procesu renderowania obrazu. W znaczący sposób ogranicza to dostępność uzyskanych efektów (środowisk immersyjnych), w naturalny sposób doprowadziło nasz zespół do zrównoleglenia prac nad wykorzystaniem silnika Unity oraz alternatywnych narzędzi przetwarzających dane i modele, umożliwiających ich konwersję na potrzeby środowisk czasu rzeczywistego (w tym narzędzi open source, np. Blender).

Mając na uwadze powyższe w toku realizacji use-case zdecydowano na dwutorowe prace, pozwalające na weryfikację założeń workflow w zakresie tworzonych środowisk czasu rzeczywistego w zależności od docelowej platformy. W przypadku wysokiej jakości (High Fidelity) środowiska stacjonarnego wykorzystano ścieżkę przetwarzania w krokach 4-5 w oparciu o Unreal Engine i dostępne mechanizmy automatyzujące konwersję (DataSmith) oraz kompozycję sceny (Nanite, Lumen), zaś w przypadku wersji mobilnej wykorzystano ścieżkę Unity w oparciu o URP. Warto zauważyć, iż na chwilę obecną Unity posiada ograniczenie w zakresie konwersji przyjętej ścieżki rendering pipeline, tzn. Istnieje możliwość jednokierunkowej konwersji z URP do bardziej zaawansowanego HDRP. Z tego powodu przygotowując uniwersalne środowisko VR, należy skupić się na wykorzystaniu URP, z zachowaniem ewentualnej możliwości konwersji do HDRP na potrzeby wysokowydajnych stacjonarnych systemów VR.

Podsumowując, w toku opracowywania use-case, bazując na wypracowanym workflow, przygotowano w oparciu o modele profesora Fuchsa (krok 3 workflow) wypracowanymi na podstawie danych źródłowych (krok 1 workflow) oraz dodatkowe dane kontekstowe (krok 2 workflow) dalsze kroki zmierzające do realizacji kolejnych etapów workflow, czyli konwersji z systemów architektonicznych BIM na potrzeby środowisk czasu rzeczywistego (krok 4), a następnie przygotowanie środowiska immerysjnego z wykorzystaniem rzeczywistości wirtualnej (krok 5), tak aby można było następnie wykorzystać je do przygotowania odpowiedniej prezentacji pełnego kontekstu rekonstrukcji cyfrowej w oparciu odpowiednie struktury, elementy i propozycje narracyjne w kontekście rekonstrukcji pierwotnego wykorzystania obiektu teatru (krok 6).

Use case teatru Volterra został wykorzystany w szeregu aktywności zaplanowanych i zrealizowanych w ramach przedsięwzięcia, m.in. warsztatach dla studentów Wydziału Sztuki Nowych Mediów. Został również zaprezentowany w Galerii PJATK jako immersyjny interaktywny pokaz z wykorzystaniem stacjonarnych i bezprzewodowych zestawów VR. Pokazom towarzyszyła multimedialna prezentacja, którą zamieszczamy poniżej:

Framework Archiverse oraz use case Volterra był również omawiany w ramach XII międzynarodowej konferencji MIDI 2024, w szczególności w trakcie specjalnego panelu poświęconemu badaniom w zakresie wykorzystania nowoczesnych technik, metod i narzędzi rzeczywistości wirtualnej (VR), rozszerzonej (AR) i poszerzonej (XR) w obszarze dziedzictwa kulturowego, z udziałem członków zespołu projektowego oraz gościa specjalnego panelu – prof. Władysław Fuchsa z Uniwersystetu Detroit-Mercy, założyciela i prezes Detroit-Volterra Foundation, autora modeli BIM teatru, na których oparty jest VR Use Case.

Bibliografia

Kopec, W., Kornacka, M., Pochwatko, G., Biele, C., Jaskulska, A., Skorupska, K., Barnes, S., Grzeszczuk, M., Nilsson, T., Fuchs, W., et al.: Co-designing immersive virtual and extended reality systems for remote and unsupervised interaction, intervention, training and research. In: IFIP Conference on Human-Computer Interaction.

pp. 610–615. Springer (2023)

Kopec, W., Pochwatko, G., Kornacka, M., Stawski, W., Grzeszczuk, M., Skorupska, K., Karpowicz, B., Maslyk, R., Zinevych, P., Knapinski, S., et al.: Human factors in space exploration: Opportunities for international and interdisciplinary collaboration. In: Machine Intelligence and Digital Interaction Conference. pp. 339–350.

Springer (2023)

Pochwatko, G., Kopec, W., Jedrzejewski, Z., Jaskulska, A., Skorupska, K.H., Karpowicz, B., Maslyk, R., Barnes, S., Grzeszczuk, M., Lazarek, J., Swidrak, J.: The invisible – experienced: Developing and verifying a vr application for understanding air pollution perception and attitudes. In: 2023 IEEE International Symposium on Mixed and Augmented Reality Adjunct (ISMAR-Adjunct). pp. 531–536 (2023)

Pochwatko, G., Kopec, W., Swidrak, J., Jaskulska, A., Skorupska, K.H., Karpowicz, B., Maslyk, R., Grzeszczuk, M., Barnes, S., Borkiewicz, P., et al.: Well-being in isolation: Exploring artistic immersive virtual environments in a simulated lunar habitat to alleviate asthenia symptoms. In: 2023 IEEE International Symposium on Mixed and Augmented Reality (ISMAR). pp. 185–194. IEEE (2023)